Hallo liebe Community,

mein Name ist Cafer Yörük, ich bin 26 Jahre alt und leidenschaftlich begeistert davon, neue Features und digitale Trends auszuprobieren. Diese Neugier hat mich nicht nur in meiner täglichen Arbeit als Head of Projektmanagement bei 8mylez begleitet, sondern war auch der Ausgangspunkt für meine Masterarbeit zum Thema „Digital Nudging im E-Commerce“ und das Einführen bei 8mylez von A/B Tests für Shopware. Dabei habe ich untersucht, wie digitale Anstupser (Nudges) das Verhalten von Kunden im Onlinehandel beeinflussen können.

In meinem Beruf erlebe ich tagtäglich, wie wichtig es ist, auf Basis von Daten und gezielten Optimierungen das Kundenerlebnis zu verbessern. Wir bei 8mylez setzen zahlreiche Ideen für unsere Kunden um – von kleinen Änderungen bis hin zu umfangreichen Shop-Optimierungen. Doch immer wieder stellen wir uns die Frage: Bringen diese Maßnahmen tatsächlich die erhofften Ergebnisse oder wirken sie sich vielleicht sogar negativ aus?

Diese Unsicherheit, die viele von uns im E-Commerce kennen, hat mich dazu gebracht, eine Lösung zu entwickeln, mit der wir verlässlich und messbar feststellen können, was wirklich funktioniert. So entstand die Idee zu Convertly – unserem Shopware-Plugin, das es ermöglicht, nahtlos A/B-Tests zu integrieren und durch datenbasierte Insights das Geschäftswachstum und die Conversion-Raten zu steigern.

Was sind A/B Tests und warum sind sie so wichtig?

A/B-Tests sind kontrollierte, randomisierte Experimente, die Unternehmen dabei unterstützen, datenbasierte Entscheidungen zu treffen. Dabei wird eine bestimmte Änderung (z. B. am Design oder Inhalt einer Webseite) in einer Testversion gegen eine Kontrollversion getestet, um ihre Auswirkungen auf die Nutzererfahrung und die Performance zu messen. Anstatt sich auf Bauchgefühl oder Annahmen zu verlassen, erlauben A/B-Tests für Shopware aber auch im Allgemeinen eine objektive Bewertung von Anpassungen, die Unternehmen helfen, das Nutzerverhalten gezielt zu optimieren.

Warum sollte man aber A/B-Tests einsetzen? A/B-Tests bieten zahlreiche Vorteile: Sie minimieren das Risiko, schlechte Ideen dauerhaft zu implementieren, da die Auswirkungen jeder Änderung direkt messbar sind. Gleichzeitig fördern sie ein tieferes Verständnis des Nutzerverhaltens, was zu langfristig steigenden Kennzahlen wie Return on Investment (ROI), Conversion Rate (CR) und Average Revenue per User (ARPU) führen kann. So wird die datengetriebene Entscheidungsfindung zum Kern der Optimierungsstrategie und trägt entscheidend zum Erfolg des digitalen Marketings bei.

Neben den klassischen A/B-Tests gibt es auch erweiterte Testformen wie A/B/n-Tests und multivariate Tests, die spezifische Anforderungen und Zielsetzungen bedienen:

A/B-Tests

- A/B Tests ist die einfachste Form des Tests, bei dem zwei Versionen (A und B) gegeneinander getestet werden. Es eignet sich ideal für isolierte Änderungen, wie zum Beispiel eine neue Call-to-Action oder ein überarbeitetes Bild auf der Webseite.

A/B/n-Tests

- Bei A/B/n-Tests werden mehrere Varianten gleichzeitig getestet, z.B. Version A, B und C. Dieser Ansatz hilft, verschiedene Versionen schneller zu evaluieren und die beste Lösung zu identifizieren. Besonders nützlich ist dies, wenn mehrere Alternativen für eine Design- oder Inhaltsanpassung vorliegen und das Nutzerfeedback direkt verglichen werden soll.

Multivariate Tests

- Diese komplexere Testform untersucht die Auswirkungen mehrerer Veränderungen gleichzeitig, z.B. eine neue Headline und ein neues Bild. Multivariate Tests sind hilfreich, um zu verstehen, wie verschiedene Elemente in Kombination das Nutzerverhalten beeinflussen. Allerdings benötigt diese Methode eine größere Stichprobengröße und eignet sich vor allem für Webseiten mit hohem Traffic.

Durch den gezielten Einsatz dieser Testtypen können Unternehmen ihre Optimierungsstrategie differenziert ausrichten und datenbasiert das Nutzererlebnis sowie die Performance ihres Online-Shops maximieren.

Welche Grundprinzipien des A/B Testings gibt es?

A/B-Testing beruht auf einigen fundamentalen Prinzipien, die sicherstellen, dass die Ergebnisse aussagekräftig und verwertbar sind. Diese Prinzipien dienen als Leitlinien, um Tests strukturiert und methodisch durchzuführen und valide Entscheidungen auf Basis der Testergebnisse zu treffen.

Zwei Versionen Ansatz

Beim klassischen A/B-Test werden eine Kontrollversion (A) und eine Testversion (B) der Seite oder Funktion erstellt. Als Besucher wirst Du zufällig auf eines der beiden Versionen zugeteilt, und kannst den Effekt der Änderung isoliert messen. So lassen sich direkte Vergleiche anstellen und fundierte Entscheidungen treffen.

Randomisierung

Ein zentraler Punkt ist die zufällige Zuweisung der Nutzer zu den Testgruppen, um Verzerrungen zu minimieren. Diese Methode stellt sicher, dass Faktoren wie Uhrzeit, Gerätetyp oder geografische Herkunft nicht die Ergebnisse beeinflussen. Damit kannst Du gewährleisten, dass die Unterschiede zwischen den Gruppen ausschließlich auf die getestete Variable zurückzuführen sind.

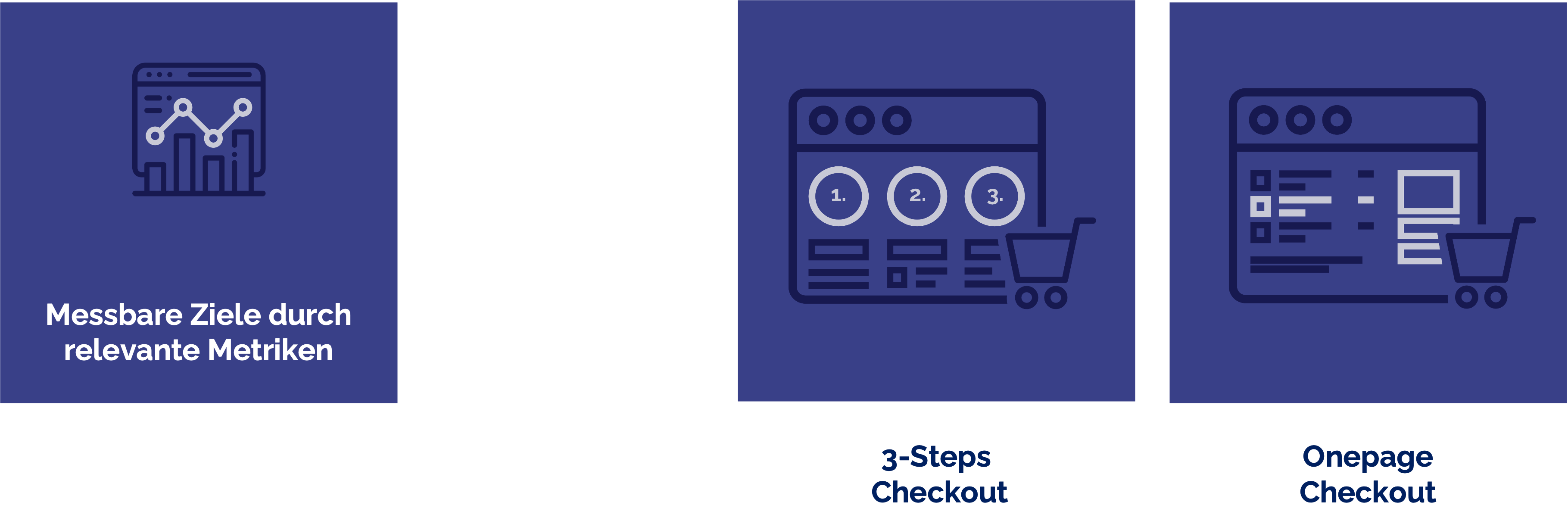

Messbare Ziele und relevante Metriken

Um den Erfolg eines Tests zu bewerten, müssen vorher klare, messbare Ziele festgelegt werden. Diese Metriken könnten beispielsweise die Abbruchrate oder die Conversion-Rate sein. Ohne diese messbaren Größen wäre eine objektive Auswertung der Ergebnisse kaum möglich.

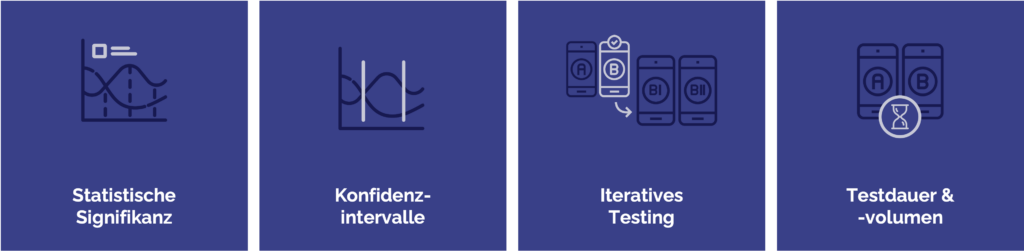

Statistische Signifikanz und Konfidenzintervalle

Ein Test ist nur dann aussagekräftig, wenn die Ergebnisse statistisch signifikant sind. Ein typischer Schwellenwert ist ein p-Wert von unter 0,05, der anzeigt, dass die beobachteten Unterschiede nicht zufällig sind. Konfidenzintervalle helfen dabei, die Präzision der Ergebnisse einzuschätzen und liefern ein Vertrauensmaß für die Gültigkeit der Testergebnisse.

Iteratives Testing

A/B-Testing ist ein kontinuierlicher Prozess. Basierend auf den gewonnenen Erkenntnissen, hast Du die Möglichkeit neue Hypothesen aufzustellen und zu testen. Diese iterative Vorgehensweise ermöglicht eine schrittweise Optimierung und Anpassung, um das Nutzererlebnis und die Conversion-Rate langfristig zu verbessern.

Testdauer und -volumen

Ein erfolgreicher A/B-Test erfordert eine ausreichende Testlaufzeit und ein angemessenes Volumen an Nutzern. Je höher der Traffic, desto präziser kannst Du auch kleine Veränderungen identifizieren. Nur so lässt sich sicherstellen, dass die Ergebnisse repräsentativ sind und für die Gesamtpopulation gültig bleiben.

Diese Grundprinzipien bieten eine stabile Grundlage für den strukturierten Einsatz von A/B-Tests und gewährleisten, dass die daraus gewonnenen Erkenntnisse wirklich zum Erfolg beitragen.

Wie könnte mein nächstes Experiment aussehen?

Eine wie ich finde sehr schwierige Frage, denn man will schließlich auch nur etwas testen, was Optimierungspotential mit sich bringt. Wie findet man allerdings Optimierungspotentiale für seinen eigenen Online-Shop? Nachdem Convertly nun erfolgreich A/B-Tests ermöglicht, stellt sich für mich die Frage: Welche neuen Experimente könnten wir als nächstes angehen, um noch tiefere Einblicke in das Verhalten unserer Kunden zu gewinnen?

Die Basis für fundierte Experimente bilden zunächst Tracking, gute Insights und Heatmaps. Mit diesen Werkzeugen kannst Du wertvolle Metriken erfassen, die direktes Feedback zum Nutzerverhalten liefern und klare Ansatzpunkte für Optimierungen identifizieren. Hier sind einige zentrale Messwerte, die als Ausgangspunkt für zukünftige Tests dienen können:

Conversion Rate

- Eines der wichtigsten Ziele im E-Commerce und Marketing. Sie misst den Prozentsatz der Nutzer, die eine gewünschte Aktion, wie den Kauf eines Produkts oder die Anmeldung zum Newsletter, tatsächlich ausführen. Änderungen an der Call-to-Action (CTA) oder am Bestellprozess könntest Du hier direkt testen.

Bounce Rate

- Dieser Wert gibt an, wie viele Besucher die Seite ohne Interaktion wieder verlassen. Eine hohe Bounce Rate kann auf Probleme wie lange Ladezeiten, unzureichende Inhalte oder schlechtes Design hinweisen. Tests könnten sich darauf konzentrieren, die Einstiegsseite attraktiver zu gestalten.

Durchschnittliche Verweildauer

- Zeigt, wie lange Nutzer im Durchschnitt auf einer Seite bleiben. Eine kurze Verweildauer könnte auf mangelndes Engagement hinweisen und Verbesserungspotenzial im Content oder Layout aufzeigen.

Durchschnittlicher Warenkorbwert (ARPU)

- Eine wichtige Kennzahl, die den durchschnittlichen Umsatz pro Nutzer beschreibt. Hier könnten Cross-Selling-Strategien oder Upselling-Möglichkeiten getestet werden, um den Warenkorbwert zu steigern.

Seiten pro Sitzung

- Gibt an, wie viele Seiten ein Nutzer durchschnittlich pro Besuch ansieht. Eine geringe Zahl kann darauf hindeuten, dass der Shop eine klarere Navigation benötigt. Ein Experiment könnte daher alternative Navigationsstrukturen prüfen.

Klickrate (CTR)

- Misst, wie oft Nutzer auf Links oder Buttons klicken. Eine niedrige CTR kann darauf hindeuten, dass CTA-Elemente überarbeitet oder prominenter platziert werden sollten.

Warenkorbabbruchrate

- Ein kritischer Wert im E-Commerce, der anzeigt, wie oft Nutzer den Kaufvorgang beginnen, aber nicht abschließen. Hier könnten Änderungen im Checkout-Prozess oder Anpassungen bei den Zahlungsmethoden wertvolle Erkenntnisse liefern.

Durch die gezielte Nutzung dieser Datenpunkte als Grundlage für Experimente lässt sich das Optimierungspotenzial maximieren und das Kundenverständnis kontinuierlich vertiefen. So führen A/B-Tests nicht nur zu kurzfristigen Erfolgen, sondern bieten eine langfristige Strategie zur Verbesserung der gesamten Customer Journey.

Hypothesen für gezielte Tests entwickeln

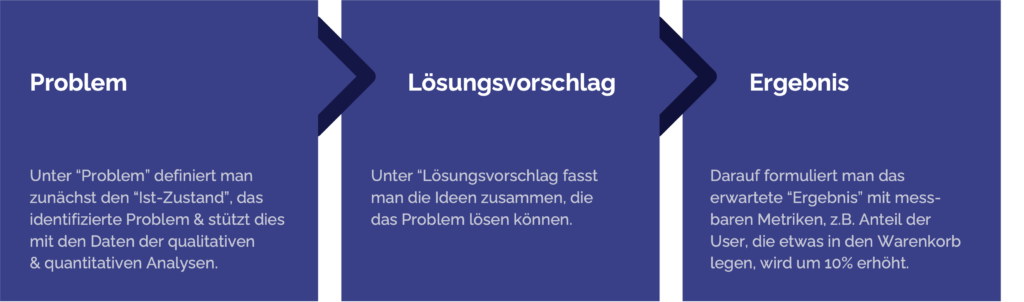

Die Ableitung einer Hypothese ist ein zentraler Schritt bei der Planung und Durchführung eines A/B-Tests. Sie bildet das Fundament für einen strukturierten Testprozess und sorgt dafür, dass die getesteten Änderungen klare Zielsetzungen und messbare Ergebnisse verfolgen.

- Problem: Zuerst wird der Ist-Zustand definiert und das spezifische Problem identifiziert, das behoben werden soll. Hierbei helfen qualitative und quantitative Analysen, die das Problem mit Daten untermauern und präzise beschreiben. Zum Beispiel könnte die aktuelle Conversion-Rate im Warenkorb-Prozess niedriger sein als erwartet.

- Lösungsvorschlag: Basierend auf der Problemanalyse werden Lösungsideen formuliert, die das identifizierte Problem adressieren sollen. Hierbei wird überlegt, welche Anpassungen potenziell zu einer Verbesserung führen könnten, wie etwa eine deutliche Platzierung des „In den Warenkorb“-Buttons oder die Vereinfachung des Checkout-Prozesses.

- Ergebnis: Abschließend wird das erwartete Ergebnis festgelegt und in Form messbarer Metriken ausgedrückt. Dies könnten zum Beispiel Ziele sein, wie die Erhöhung der Anzahl der Nutzer, die ein Produkt in den Warenkorb legen, um 10 %. Die klare Definition eines Zielwertes ermöglicht eine objektive Bewertung des Testerfolgs.

Durch die präzise Hypothesenbildung wird sichergestellt, dass der A/B-Test nicht nur isolierte Änderungen überprüft, sondern gezielte und datengetriebene Optimierungen ermöglicht. So kann der Testprozess zu einem wertvollen Werkzeug zur nachhaltigen Verbesserung der User Experience und zur Maximierung der Geschäftsergebnisse werden.

Ab wann sind A/B-Tests sinnvoll und wie werte ich sie aus?

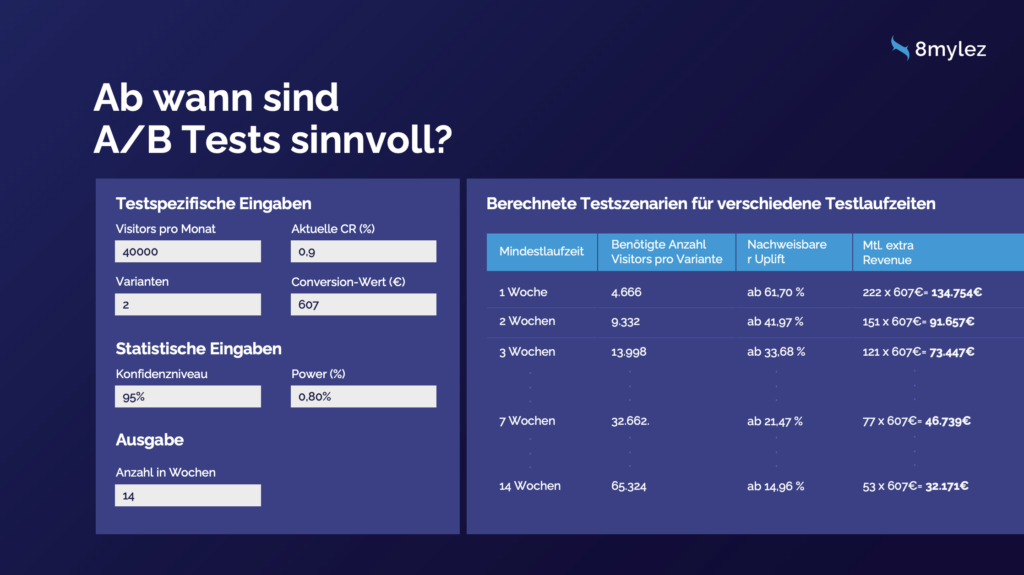

A/B-Tests für Shopware sind besonders dann sinnvoll, wenn ausreichend Traffic auf der Webseite vorhanden ist und die zu erwartende Effektgröße messbar ist. Ein Online-Shop mit hohem Besucheraufkommen kann bereits bei kleinen Optimierungen signifikante Ergebnisse erzielen. Bei geringem Traffic kann es hingegen sinnvoll sein, längere Testzeiträume anzusetzen, um genügend Daten für aussagekräftige Resultate zu sammeln. Vor dem Start sollte ein klares Verständnis über die Ziel-Metriken (z. B. Conversion Rate, durchschnittlicher Warenkorbwert) und das gewünschte Konfidenzniveau bestehen.

Ein Beispiel zeigt, wie man testrelevante Daten für verschiedene Szenarien einsetzt. Mit 40.000 Besuchern pro Monat, einer aktuellen Conversion Rate von 0,9 % und einem Conversion-Wert von 607 € lassen sich die nötigen Mindestlaufzeiten und die erwarteten Effekte berechnen. Für eine Woche wären zum Beispiel mindestens 4.666 Besucher pro Variante notwendig, um einen nachweisbaren Uplift von 61,7 % zu erreichen, was zusätzlichen Umsatz von ca. 134.754 € monatlich bedeuten könnte. Längere Testzeiträume wie zwei oder drei Wochen reduzieren die notwendige Besucherzahl und können auch geringere Uplifts nachweisen, die dennoch finanziell lohnend sind.

Zur Auswertung der Ergebnisse kommen statistische Methoden zum Einsatz. Die Berechnung des Konfidenzintervalls spielt hierbei eine zentrale Rolle, da es Aufschluss darüber gibt, ob das beobachtete Ergebnis signifikant ist und somit auf die Gesamtpopulation übertragbar wäre. Mit einer Standardformel lässt sich das Konfidenzintervall für die Conversion Rate schätzen und so die Sicherheit der Resultate bewerten. Nur wenn das Ergebnis innerhalb des festgelegten Konfidenzintervalls liegt, kann man davon ausgehen, dass es nicht zufällig ist. Das ist allerdings ein Thema, zu dem ich noch ausführlicher in einem zukünftigen Blog Beitrag eingehen werde.

Wie starte ich A/B-Tests mit Convertly in Shopware 6?

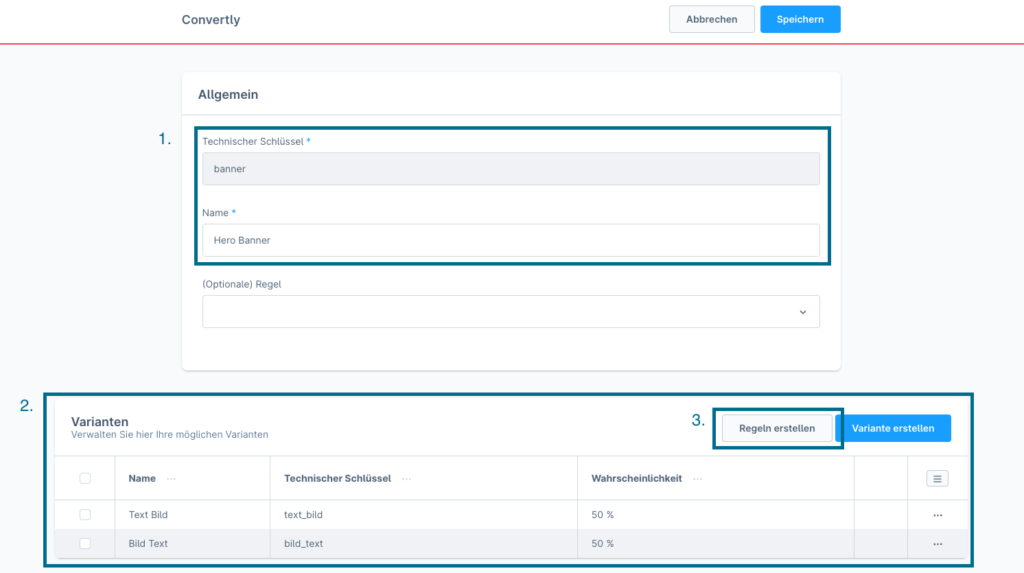

Nun wollen wir aber von der Theorie in die Praxis und zum Glück ist die Erstellung eines A/B-Tests für Shopware mit Convertly einfach. In diesem Beispiel wollen wir den Hero Banner beispielhaft im Shop gegeneinander testen.

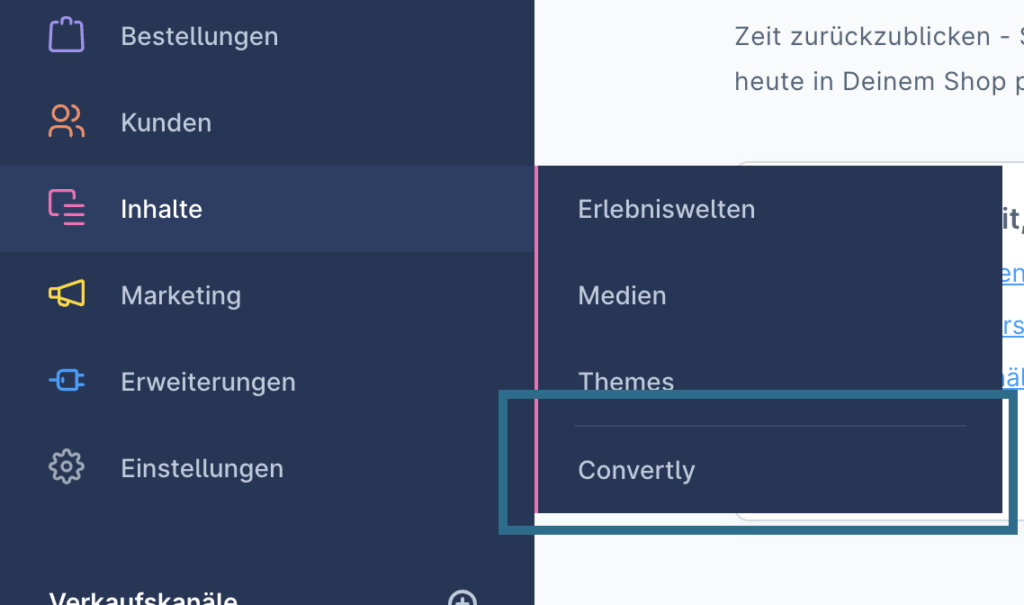

Nachdem Du im Shopware Store unser Convertly Plugin erworben hast, installiere und aktivere das Plugin. Gehe anschließend in Deinem Shopware-Dashboard zu „Inhalte“ > „Convertly“.

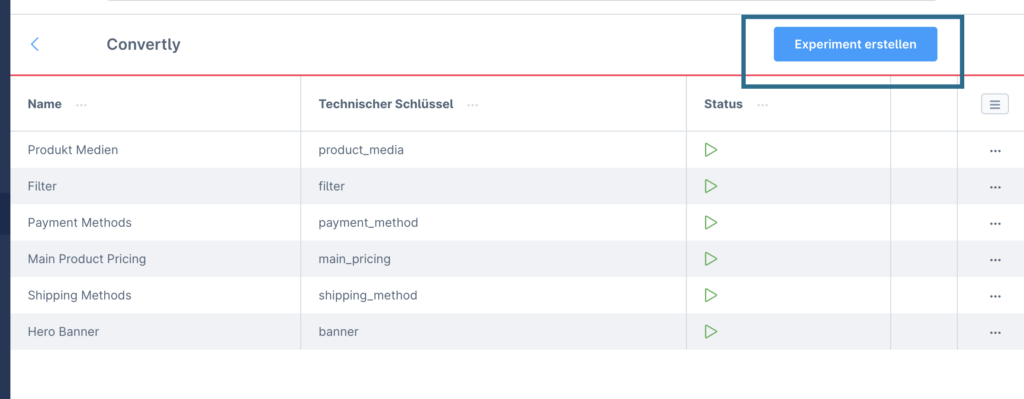

Nachdem Du zur Übersicht gelangt bist, klicke auf „Experiment erstellen“, um ein neues A/B-Test-Experiment zu starten.

Füge Varianten hinzu und gib ihnen einen Namen sowie eine Ausspielungs-Wahrscheinlichkeit. Diese Wahrscheinlichkeit gibt an mit welcher Wahrscheinlichkeit ein Nutzer die angelegte Variante angezeigt bekommen. Um ein gut durchgeführtes und vorallem randomisierten A/B Test zu fahren, ist es essentiell, dass alle Varianten die gleiche Ausspielungs-Wahrscheinlichkeit haben.

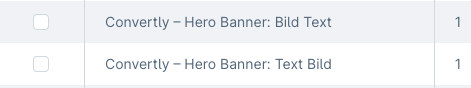

Nutze den Rule Builder, um Regeln den verschiedenen Varianten zuzuweisen. Mit Klick auf „Regeln erstellen“ werden demnach automatisch Regeln für die beiden Varianten erstellt. Diese findest Du nun in der Übersicht der Rules und würde in unserem Beispiel folgendermassen ausschauen:

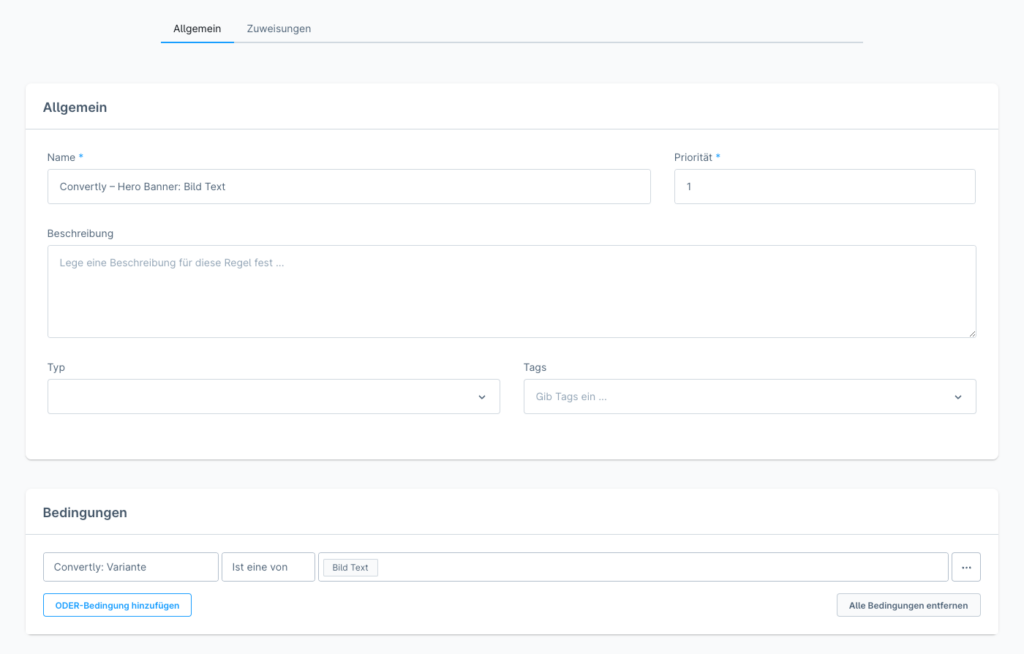

Mit Convertly wird eine neue Rule Variable in Shopware erstellt, welche eine Ausprägung als Bedingung zuweist und dadurch das Zuordnen der Varianten ermöglicht wird. Eine Regel sieht dann folgendermassen aus:

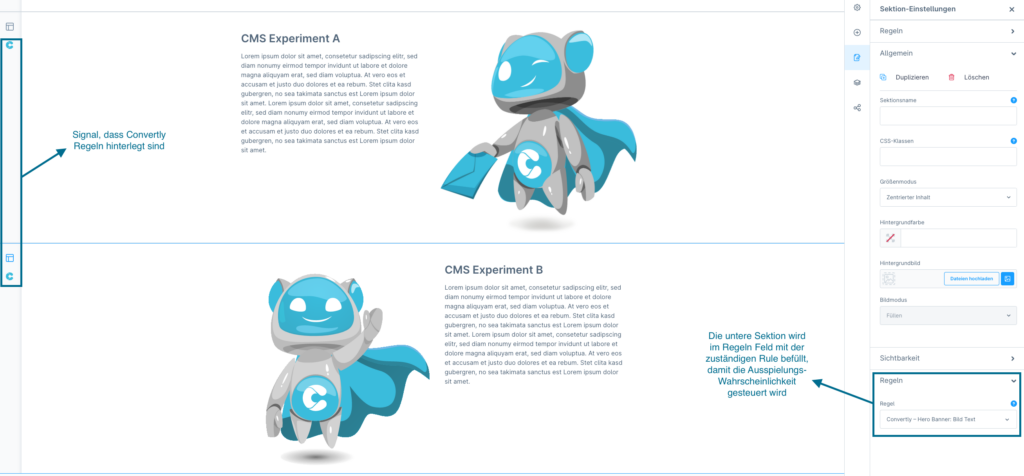

Der finale Schritt in der Einrichtung des Tests ist nun, dass die beiden Regeln jeweils den beiden Sektionen oder CMS Elementen innerhalb der Erlebniswelt. Hierfür erstellt Convertly in den Erlebniswelten ein neues Feld für „Regeln“.

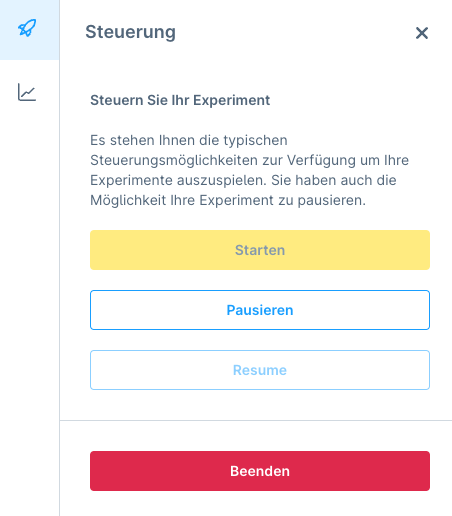

Nun kannst Du den Test im Convertly Dashboard starten und die Auswertungen mitverfolgen. Wichtig ist, dass nach dem Starten des Experiments der Shop Cache nochmal geleert wird, damit ganz sicher alle Änderungen greifen. Viel Spaß beim Testen! 🙂

Nudging als A/B-Test Methode: Die subtile Kunst, Verhalten zu beeinflussen

Nudging bezeichnet die Gestaltung der Entscheidungsarchitektur, die das Verhalten von Menschen auf vorhersagbare Weise beeinflusst, ohne Optionen einzuschränken oder wirtschaftliche Anreize zu verändern. Richard Thaler und Cass Sunstein (2008) prägten diesen Begriff und zeigen, wie kleine, gezielte Änderungen das Verhalten in gewünschte Richtungen lenken können – eine Methode, die auch im A/B-Testing effektiv genutzt werden kann.

Im Rahmen von A/B-Tests für Shopware kann Nudging verschiedene Formen annehmen: Evaluation Kontext bezieht sich auf den Vergleichsrahmen, in dem Optionen präsentiert werden; Framing betrifft die Wortwahl und Darstellungsweise, die die Wahrnehmung von Optionen beeinflusst; der Decoy-Effekt stellt eine zusätzliche Option zur Verfügung, die eine andere Wahl attraktiver erscheinen lässt. Weitere Ansätze können den Entscheidungsprozess subtil steuern und gewünschte Handlungen fördern.

Durch den Einsatz von Nudging-Techniken im A/B-Testing können Unternehmen gezielt das Verhalten ihrer Nutzer lenken und somit eine optimierte User Experience schaffen. Ohne Zwang oder zusätzliche Kosten für den Nutzer werden Entscheidungen durch clevere Gestaltung und psychologisches Feingefühl beeinflusst. So wird A/B-Testing nicht nur zu einem Instrument der Erfolgsmessung, sondern zu einer Strategie, das Nutzerverhalten nachhaltig und positiv zu beeinflussen.

Schlusswort

Zusammenfassend lässt sich sagen: Mit den richtigen A/B-Tests und gut durchdachten Hypothesen kannst Du Deine Shop-Performance nachhaltig verbessern und die Conversion Rates steigern. Hast Du bereits Ideen für Deinen nächsten Test? Lass uns in den Kommentaren wissen, welche Methoden für Dich am besten funktioniert haben – oder starte gleich mit Convertly und optimiere Deinen Shopware Shop datenbasiert! Kontaktiere mich auch gerne für eine individuelle Beratung!